在大数据时代,数据量的激增对数据架构设计提出了更高的要求。传统的数据处理方式已难以满足实时性、可扩展性和灵活性的需求。因此,构建一个高效的数据架构成为企业数据战略的关键。

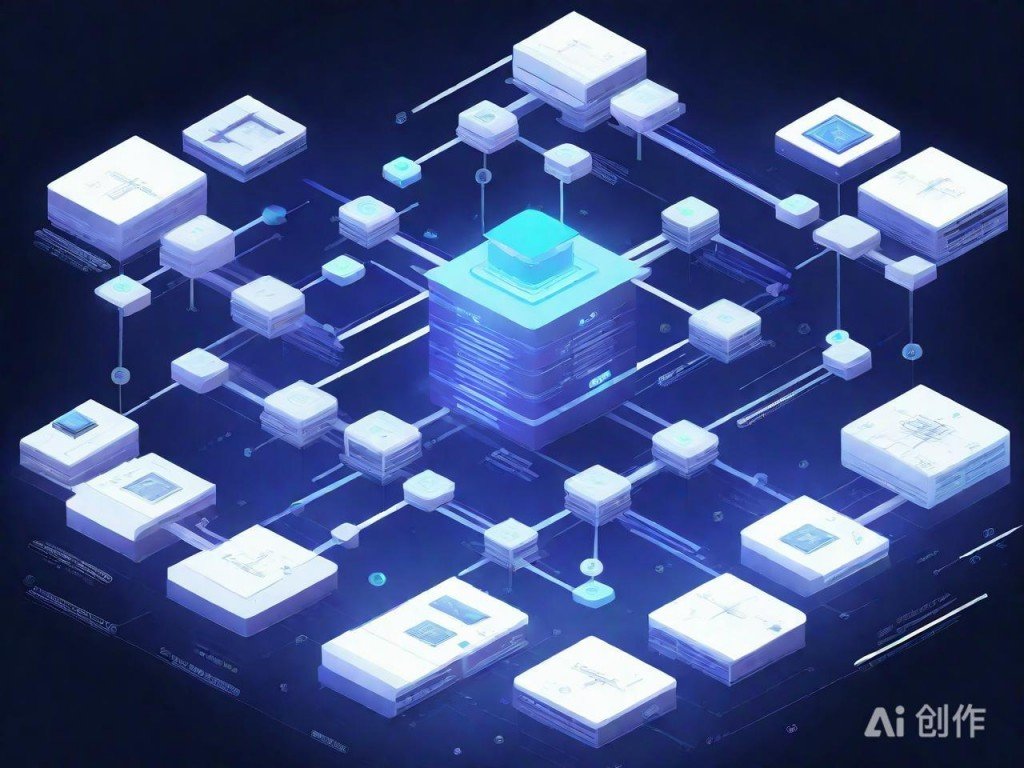

数据架构的核心在于合理规划数据的存储、流转与处理路径。通过分层设计,如数据采集层、存储层、计算层和应用层,可以实现数据的有序流动,降低系统复杂度。同时,选择合适的存储技术,如分布式文件系统或云原生数据库,能显著提升数据处理效率。

构建高效Pipeline是实现数据价值的重要手段。Pipeline的设计需关注数据流的并行处理与任务调度,利用流式计算框架如Apache Flink或Spark Streaming,可以实现低延迟的数据处理。•引入监控与日志机制有助于及时发现和解决问题,保障Pipeline的稳定性。

AI绘图结果,仅供参考

数据质量与安全同样不可忽视。在Pipeline中嵌入数据校验逻辑,确保输入数据的准确性;同时,通过权限控制与加密传输,保护敏感信息不被泄露。这些措施共同构成了数据处理的完整生态。

最终,数据架构与Pipeline的设计应以业务需求为导向,持续优化与迭代。只有不断适应变化,才能在大数据环境中保持竞争力。